現貨庫存,2小時發貨,提供寄樣和解決方案

熱搜關鍵詞:

近期,美光發布的內存和存儲產品組合備受矚目,這些新成就為AI技術的飛速發展增添了活力。美光推出的8層堆疊和12層堆疊HBM3E解決方案在業界引領潮流,其功耗比競品低30%。特別引人注目的8層堆疊24GB HBM3E產品將應用于NVIDIA H200 Tensor Core GPU中。在最近的Six Five Media節目中,主持人Daniel Newman(Futurum Group首席執行官)和Patrick Moorhead(Moor Insights & Strategy首席執行官)與美光產品管理高級總監Girish Cherussery進行了視頻訪談。他們深入探討了高帶寬內存(HBM)在廣泛市場上的應用以及其在當今科技領域的多重應用。以下是他們的討論回顧,內容涉及了HBM的復雜性、美光如何迎合市場需求以及當前內存生態系統的發展動向,同時,Girish還分享了對AI內存和存儲技術市場趨勢的寶貴見解。

高帶寬內存(HBM)作為業界標準的封裝內存產品,具有革命性意義。其小巧尺寸下實現更高的容量和能效。正如Girish在Six Five播客節目中所指出的,隨著AI應用中越來越多復雜的大型語言模型(LLM)部署,GPU內存容量和帶寬不斷受到挑戰。大型語言模型的規模呈指數級增長,超過內存容量增長速度,這凸顯了對內存容量不斷增加的需求。

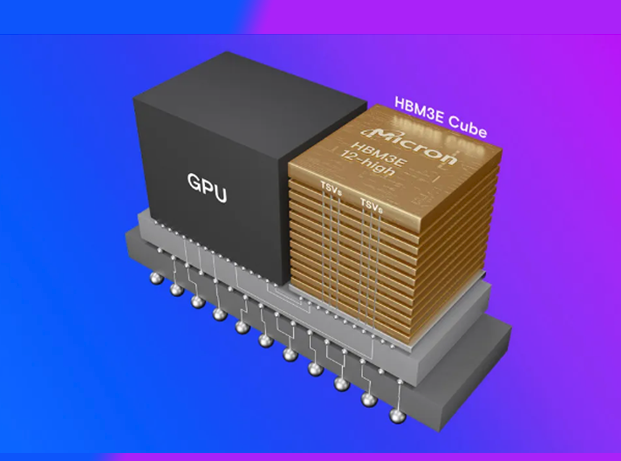

以GPT-3為例,該模型大約有1750億個參數,這意味著需要約800GB內存及更高的帶寬,以避免性能瓶頸。而最新的GPT-4模型參數更多(預計達到萬億級)。傳統方法增加內存器件會導致系統成本劇增。而HBM則提供了一種高效解決方案。美光基于其領先的1β技術,推出了11mm x 11mm封裝規格的8或12層24Gb裸片HBM3E內存,容量達24GB或36GB。美光先進的設計和工藝創新,助力HBM3E實現超過1.2TB/s的內存帶寬和超過9.2Gb/s的引腳速率。正如Girish所言,HBM3E具備16個獨立的高頻數據通道,如"高速公路車道",可快速傳輸數據,提供所需性能。

美光的HBM3E具有更高的容量和帶寬,縮短了大型語言模型的訓練時間,幫助客戶節省成本。HBM3E容量更大,支持更大規模的大型語言模型,有助于避免CPU卸載和GPU之間的通信延遲。HBM3E功耗極低,因為主機和內存之間的數據路徑較短。通過硅通孔(TSV)與主機通信,HBM3E的功耗比競爭對手低30%,在每個內存實例8Gbps速率下,功耗減少30%。以擁有500,000個GPU的客戶為例,僅5年內就能節省超過1.23億美元運營成本。因此,正如Daniel Newman所說,美光的HBM3E內存在容量、速度和功耗方面表現出色,對于數據中心的可持續發展需求產生積極影響。如需產品規格書、樣片測試、采購、BOM配單等需求,請加客服微信:13310830171。